안녕하세요. 제가 요즘 머신러닝을 이용한 빅데이터 분석하는 프로젝트에 관심이 많아서, 공부하는 김에 대표 앙상블 기법들 정리해봤습니다. ~~~ 여러분도 화이팅!

머신러닝 프로젝트에서 단일 모델의 성능 한계에 부딪혔을 때, 여러 모델을 지혜롭게 결합하여 예측 정확도와 안정성을 비약적으로 향상시키는 **앙상블 학습(Ensemble Learning)**은 매우 강력한 해법입니다. 앙상블 학습은 마치 다양한 분야의 전문가들이 모여 하나의 정교한 결론을 도출하는 '집단 지성'의 원리와 유사합니다. 이 글에서는 머신러닝 앙상블 모델의 핵심 개념과 원리, 대표적인 기법들, 그리고 이러한 모델들을 최적으로 활용하기 위한 구체적인 전략과 최신 연구 동향까지 심층적으로 탐구해 보겠습니다.

앙상블 학습의 정수: 왜 여러 모델을 함께 사용할까?

앙상블 학습은 여러 개의 개별 모델, 즉 기본 학습기(base learners) 또는 약한 학습기(weak learners)를 결합하여 단일의, 일반적으로 더 강건하고 정확한 예측 모델을 생성하는 머신러닝 패러다임입니다. 근본적인 아이디어는 개별 전문가 모델보다 모델들의 "위원회"가 종종 더 나은 결정을 내릴 수 있다는 것입니다. 이러한 접근 방식은 다양한 모델의 집단적 강점을 활용하여 개별 모델의 약점을 완화합니다.

앙상블 학습의 핵심 근거는 "학습기의 집합체가 개별 학습기보다 전반적으로 더 큰 정확성을 산출한다"는 것입니다. 때때로 "군중의 지혜(wisdom of the crowd)"라고도 불리는 이 원칙은 다양한 관점이나 모델을 결합하면 우수한 결과를 가져올 수 있음을 시사합니다. 앙상블 방법은 모델이 보지 못한 데이터에 대해 정확한 예측을 하는 능력인 일반화 성능을 향상시키는 것을 목표로 합니다. 이는 단일 모델 접근 방식에서 지속될 수 있는 오류를 줄임으로써 달성됩니다. 군중 지혜 원칙은 단순히 오류를 평균화하는 것을 넘어, 개별 모델이 놓칠 수 있는 데이터의 다양한 측면을 포착하는 데 그 의미가 있습니다. 기본 학습기가 다양하다면 서로 다른 종류의 오류를 범할 가능성이 높으며, 이를 결합하면 오류가 상쇄되거나 데이터에 대한 더 완전한 그림을 제공할 수 있습니다. 문헌들은 최적의 앙상블이 가능한 한 서로 다른, 정확도가 향상된 분류기로 구성되며 각 분류기가 고유한 오류를 생성하면 전체 오류가 감소한다고 명시합니다.

앙상블 학습의 존재와 성공은 단일 모델 패러다임의 본질적인 한계, 즉 복잡한 실제 데이터 분포를 완벽하게 포착하는 단일 가설을 찾기 어렵다는 점을 강조합니다. 가설 공간에 잘 맞는 가설이 포함되어 있더라도 좋은 가설을 찾기가 매우 어려울 수 있으며, 앙상블은 여러 가설을 결합합니다. 일반적인 머신러닝 모델의 한계와 잠재적인 실수를 인식하는 것이 앙상블 학습의 핵심 개념입니다. 앙상블의 광범위한 채택과 입증된 효능은 복잡한 작업에 대해 단일 모델에 의존하는 것이 종종 차선책임을 시사합니다. 따라서 앙상블 학습은 단일의 "완벽한" 모델을 찾기 어렵다는 점을 수용하고, 여러 개의 "불완전하지만 다양한" 모델을 결합하는 것이 종종 우수하다는 실용적인 모델 구축 접근 방식입니다.

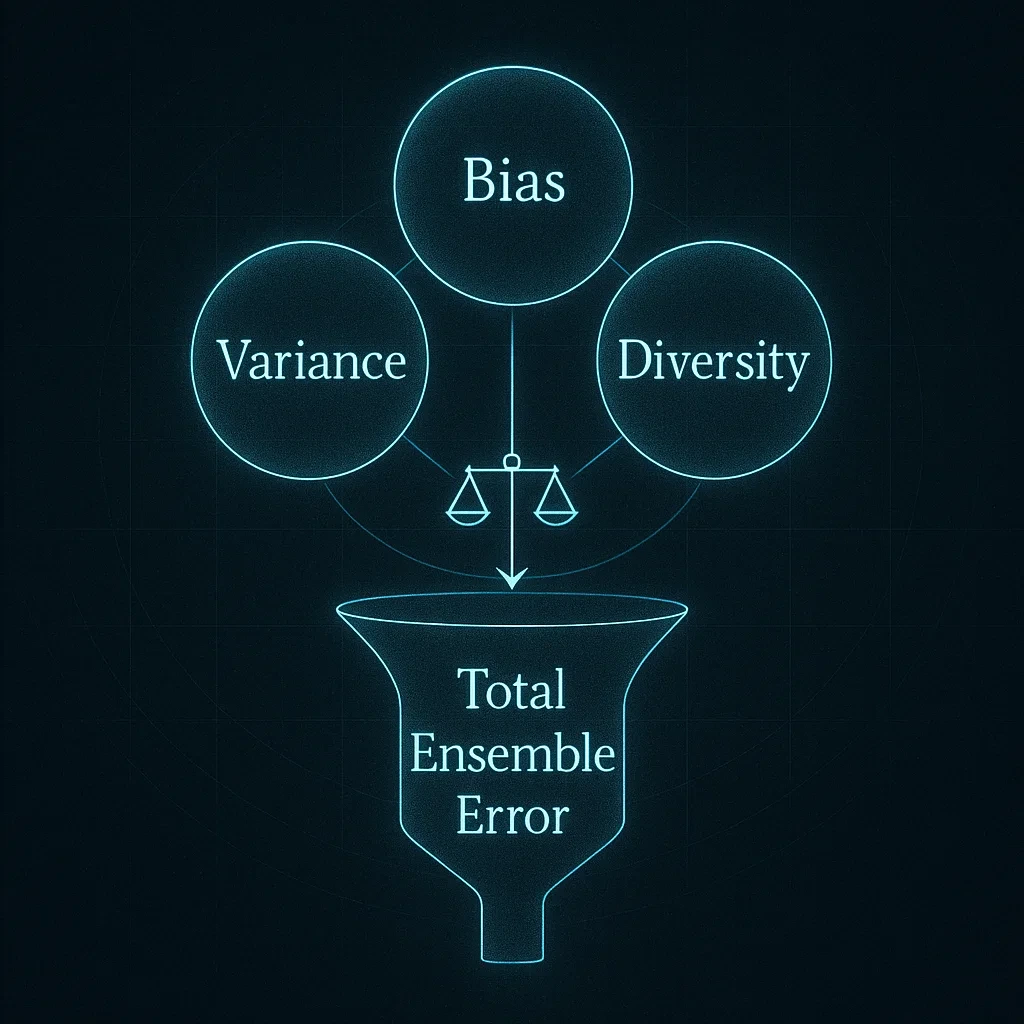

편향-분산 트레이드오프: 앙상블의 주요 동기

편향-분산 트레이드오프(Bias-Variance Trade-off)는 머신러닝에서 중심적인 문제로, 모델은 과소적합(높은 편향)과 과대적합(높은 분산) 사이의 균형을 맞춰야 합니다.

- 편향(Bias): 학습 알고리즘의 잘못된 가정으로 인한 오류입니다. 높은 편향은 알고리즘이 특징과 목표 출력 간의 관련 관계를 놓치게 할 수 있습니다(과소적합).

- 분산(Variance): 훈련 세트의 작은 변동에 대한 민감도로 인한 오류입니다. 높은 분산은 알고리즘이 의도한 출력이 아닌 훈련 데이터의 무작위 노이즈를 모델링하게 할 수 있습니다(과대적합).

앙상블 방법은 이러한 트레이드오프를 해결하기 위해 설계되었습니다.

- 배깅(Bagging) 방법은 주로 분산을 줄이는 것을 목표로 합니다.

- 부스팅(Boosting) 방법은 주로 편향을 줄이는 것을 목표로 합니다.

여러 모델을 결합함으로써 앙상블은 단일 모델보다 편향과 분산을 모두 더 효과적으로 관리하여 전반적으로 낮은 오류율을 달성할 수 있습니다. 연구에 따르면 다양하고 정규화가 덜 된(훈련 데이터에 과대적합된) 모델로 구성된 앙상블이 단일 정규화 모델보다 성능이 우수할 수 있습니다. 앙상블이 편향-분산 트레이드오프를 관리하는 데 효과적인 이유는 학습 과정을 분리할 수 있기 때문입니다. 개별 기본 학습기는 높은 분산(예: 배깅의 복잡한 결정 트리) 또는 높은 편향(예: 부스팅의 간단한 결정 스텀프)에 취약할 수 있지만, 집계 과정(배깅의 경우 평균화, 부스팅의 경우 순차적 수정)은 이러한 개별적인 약점을 집단적인 강점으로 전환합니다. 배깅은 서로 다른 데이터 하위 집합에서 모델을 독립적으로 훈련하고 그 출력을 평균화하여 개별 모델 분산을 완화합니다. 부스팅은 이전 모델의 오류에 초점을 맞춰 순차적으로 모델을 훈련하며, 이는 앙상블의 전체 편향을 반복적으로 줄입니다.

우수한 예측력을 위한 다중 학습기 집계

핵심 아이디어는 여러 모델(기본 학습기)의 예측을 결합하면 단일 모델에 의존하는 것보다 더 나은 성능을 얻을 수 있다는 것입니다. 이는 종종 서로 다른 모델이 데이터의 서로 다른 측면을 학습하거나 서로 다른 유형의 오류를 만들기 때문입니다. 집계 과정 자체는 평균화 또는 다수결 투표와 같은 간단한 방법에서부터 가중 평균화 또는 메타 학습기 사용과 같은 더 복잡한 방법에 이르기까지 다양할 수 있습니다. 연구에 따르면 앙상블 모델은 일반적으로 단일 ML 모델보다 더 정확한 결과를 달성합니다. 예를 들어, 한 문헌은 10-15%의 오류율 감소를 언급하고, 다른 문헌은 12-18%의 정확도 향상을 보여주는 연구를 인용합니다.

"우수한 예측력"은 단순히 더 높은 정확도 점수만을 의미하는 것이 아니라, 종종 잡음이 있는 데이터나 데이터셋 이동이 있는 경우에도 견고성과 신뢰성이 향상됨을 의미합니다. 단일 모델은 이러한 변동에 취약할 수 있지만, 앙상블은 집계된 특성으로 인해 이러한 효과를 완화할 수 있습니다. 앙상블은 개별 모델 오류에 더 강건하고 잡음이 많거나 복잡한 데이터에 대해 신뢰할 수 있습니다. 이상치가 한 모델을 왜곡할 수 있지만 예측이 집계될 때 그 영향이 감소하기 때문에 앙상블이 잡음 있는 데이터를 더 잘 처리한다고 설명합니다. 따라서 집계는 버퍼 역할을 하여 앙상블이 훈련 데이터의 특이성이나 단일 기본 학습기의 특정 약점에 덜 민감하게 만듭니다. 이는 데이터가 불완전한 실제 시나리오에서 더 안정적이고 신뢰할 수 있는 예측으로 이어집니다.

앙상블 모델의 분류

앙상블 방법은 기본 학습기가 생성되고 결합되는 방식에 따라 광범위하게 분류될 수 있습니다.

- 병렬 방법 (Parallel Methods): 기본 학습기는 독립적으로(병렬로) 훈련됩니다. 배깅과 랜덤 포레스트가 대표적인 예입니다. 이는 다시 다음과 같이 나뉩니다.

- 동종 병렬 앙상블 (Homogeneous Parallel Ensembles): 모든 학습기에 동일한 기본 학습 알고리즘을 사용합니다 (예: 랜덤 포레스트는 여러 결정 트리를 사용).

- 이종 병렬 앙상블 (Heterogeneous Parallel Ensembles): 서로 다른 기본 학습 알고리즘을 사용합니다 (예: 스태킹은 종종 다양한 모델을 기본 학습기로 사용).

- 순차 방법 (Sequential Methods): 기본 학습기는 순차적으로 훈련되며, 각 새로운 학습기는 이전 학습기의 오류를 수정하려고 시도합니다. 부스팅이 주요 예이며, 이들은 일반적으로 동종입니다 (예: 에이다부스트는 종종 결정 스텀프를 사용).

또 다른 분류는 기본 학습기의 유형에 기반합니다:

- 동종 앙상블 (Homogeneous Ensembles): 모든 기본 학습기가 동일한 유형입니다 (예: 랜덤 포레스트의 모든 결정 트리).

- 이종 앙상블 (Heterogeneous Ensembles): 기본 학습기가 서로 다른 유형입니다 (예: 스태킹에서 SVM, 신경망, 결정 트리 결합).

병렬/순차 및 동종/이종 앙상블 간의 선택은 해결하려는 특정 문제와 편향 감소, 분산 감소, 계산 비용 및 모델 복잡성 간의 원하는 균형에 따라 달라집니다. 배깅과 같은 병렬 방법은 분산 감소에 좋고 병렬화가 용이하여 자원이 있는 경우 훈련 시간을 줄일 수 있으며, 종종 동종 학습기를 사용합니다. 부스팅과 같은 순차 방법은 편향 감소에 좋지만 본질적으로 순차적이어서 훈련 시간이 늘어날 수 있으며, 이들도 일반적으로 동종 (종종 약한) 학습기를 사용합니다. 특히 스태킹의 이종 앙상블은 다양한 모델 아키텍처의 고유한 강점을 활용하여 광범위한 패턴을 포착하는 것을 목표로 하며, 잠재적으로 더 높은 정확도를 제공하지만 복잡성과 계산 비용도 증가시킵니다.

주요 앙상블 기법 심층 분석: 종합 연구 결과

이제 대표적인 앙상블 기법들의 작동 방식, 강점과 약점, 그리고 실제 적용 시 고려 사항들을 자세히 살펴보겠습니다.

A. 배깅 방법 (예: 랜덤 포레스트)

- 핵심 메커니즘 및 이론적 기반 배깅(Bagging), 즉 부트스트랩 집계(Bootstrap Aggregating)는 부트스트랩 샘플링(원본 데이터셋에서 중복을 허용하여 무작위로 샘플링)을 통해 여러 개의 훈련 데이터셋을 생성하는 과정을 포함합니다. 기본 학습기(일반적으로 모두 동일한 알고리즘을 사용하여 동종 앙상블을 구성)는 각 부트스트랩된 샘플에 대해 독립적으로 훈련됩니다. 그런 다음 모든 기본 학습기의 예측은 분류의 경우 다수결 투표 또는 회귀의 경우 평균화를 통해 집계되어 최종 앙상블 예측을 형성합니다.**랜덤 포레스트(Random Forest)**는 결정 트리를 기본 학습기로 사용하는 배깅의 구체적이고 널리 사용되는 구현입니다. 결정 트리 구성 시 각 분할에서 특징의 무작위 하위 집합을 선택하여 무작위성의 추가 계층을 도입하며, 이는 트리 간의 다양성을 더욱 촉진합니다.

- 경험적 성능: 강점 (예: 분산 감소, 과대적합에 대한 견고성)

- 분산 감소: 배깅의 주요 강점은 모델의 분산을 줄여 안정성과 정확도를 향상시키는 능력입니다. 약간 다른 데이터로 훈련된 여러 모델의 예측을 평균화함으로써 개별 복잡한 모델(예: 깊은 결정 트리)에 내재된 노이즈와 불안정성이 완화됩니다.

- 과대적합 감소: 결과적으로 배깅, 특히 랜덤 포레스트는 과대적합에 강합니다. 앙상블은 단일 복잡한 모델에 비해 훈련 데이터를 기억할 가능성이 적습니다.

- 정확도 향상: 여러 모델을 결합하면 일반적으로 개별 모델보다 더 나은 예측 성능을 얻을 수 있습니다.

- 결측치 처리: 랜덤 포레스트는 데이터의 결측치를 효과적으로 처리할 수 있습니다.

- 특징 중요도 추정: 랜덤 포레스트는 특징 중요도 측정값을 제공하여 데이터 이해 및 특징 선택에 유용할 수 있습니다.

- 확인된 한계 및 실제 고려 사항

- 편향: 배깅은 편향을 줄이는 데 효과적이지 않습니다. 기본 학습기가 편향되어 있으면(예: 과소적합되는 단순 모델), 배깅은 편향된 앙상블을 초래할 가능성이 높습니다. 기본 학습기가 너무 단순하면 과소적합되기 쉽습니다.

- 계산 비용 및 자원: 여러 모델을 훈련하는 것은 단일 모델을 훈련하는 것보다 계산 집약적이며 더 많은 자원(메모리, 시간)을 필요로 할 수 있습니다. 그러나 기본 학습기는 독립적으로 훈련되므로 배깅은 병렬화가 매우 용이합니다.

- 해석 가능성: 개별 결정 트리는 해석 가능하지만, 랜덤 포레스트(많은 트리의 앙상블)는 "블랙박스"가 되어 예측 뒤의 정확한 추론을 이해하기 더 어려워질 수 있습니다.

- 노이즈가 많은 데이터에 대한 성능: 일반적으로 견고하지만, 랜덤 포레스트는 매우 높은 수준의 노이즈가 있는 데이터셋에서는 어려움을 겪을 수 있으며, 적절히 조정되지 않으면 노이즈에 과대적합될 수 있습니다.

- 매개변수 조정: 랜덤 포레스트는 최적의 성능을 위해 여전히 하이퍼파라미터 조정(예: 트리 수, 트리 깊이, 분할 당 특징 수)이 필요합니다.

배깅의 병렬화 가능성은 멀티코어 CPU 및 분산 시스템을 갖춘 현대 컴퓨팅 환경에서 중요한 실용적 이점입니다. 이는 여러 모델을 훈련하는 데 드는 계산 부하 증가를 상쇄하여 대규모 데이터셋에 대해 실현 가능하게 만들 수 있습니다. 기본 학습기를 독립적으로 훈련하므로, 이러한 모델을 병렬로 훈련하여 계산 효율성을 높일 수 있습니다.

B. 부스팅 방법 (예: 에이다부스트, 그래디언트 부스팅, XGBoost, LightGBM, CatBoost)

- 핵심 메커니즘 및 이론적 기반 (순차 학습, 오류 수정) 부스팅은 기본 학습기(종종 결정 스텀프와 같은 약한 학습기)가 반복적으로 훈련되는 순차적 앙상블 기법입니다. 각 새로운 학습기는 이전에 훈련된 학습기 앙상블이 만든 오류를 수정하는 데 중점을 둡니다. 이전 학습기에 의해 잘못 분류된 인스턴스에는 더 높은 가중치가 부여되거나, 후속 학습기는 이전 앙상블의 잔차(오류)에 대해 훈련됩니다. 최종 예측은 일반적으로 모든 기본 학습기의 예측을 가중 결합한 것입니다.

- 에이다부스트(AdaBoost, Adaptive Boosting): 이전 학습기의 오류를 기반으로 훈련 인스턴스의 가중치를 조정합니다. 잘못 분류된 인스턴스는 더 높은 가중치를 받아 후속 학습기가 해당 인스턴스에 집중하도록 합니다.

- 그래디언트 부스팅 머신(GBM, Gradient Boosting Machines): 이전 모델의 잔차(오류)를 예측하는 새로운 모델(일반적으로 결정 트리)을 순차적으로 추가합니다. 경사 하강법과 유사한 절차를 사용하여 미분 가능한 손실 함수를 최적화합니다.

- XGBoost(Extreme Gradient Boosting): 그래디언트 부스팅의 최적화되고 정규화된 구현입니다. 주요 특징으로는 L1/L2 정규화, 트리 구성을 위한 병렬 처리(트리 수준이 아닌 노드 수준), 결측치 처리, 트리 가지치기 등이 있습니다.

- LightGBM(Light Gradient Boosting Machine): 특히 대규모 데이터셋에서 빠른 훈련 속도와 효율성을 위해 히스토그램 기반 알고리즘과 리프 단위(leaf-wise) 트리 성장을 사용하는 GBM 프레임워크입니다. GOSS(Gradient-based One-Side Sampling) 및 EFB(Exclusive Feature Bundling)를 통합합니다.

- CatBoost: 범주형 특징을 자동으로 효과적으로 처리하는 데 특히 능숙한 GBM 변형으로, 종종 광범위한 전처리 없이도 가능합니다. 과대적합을 방지하기 위해 순서형 부스팅(ordered boosting)과 대칭 트리를 사용합니다.

- 경험적 성능: 강점 (예: 편향 감소, 높은 정확도)

- 편향 감소: 부스팅의 주요 강점은 편향을 줄여 모델이 데이터의 복잡한 패턴을 포착할 수 있도록 하는 능력입니다.

- 높은 예측 정확도: 부스팅 알고리즘, 특히 XGBoost, LightGBM, CatBoost와 같은 최신 구현은 정형/표 형식 데이터에 대해 종종 최첨단 성능을 보이며 머신러닝 대회에서 자주 우승합니다.

- 유연성: 다양한 손실 함수 및 기본 학습기와 함께 작동할 수 있습니다 (결정 트리가 가장 일반적임).

- 결측치 및 범주형 특징 처리 (XGBoost, LightGBM, CatBoost): 고급 부스팅 알고리즘에는 이에 대한 내장 메커니즘이 있습니다.

- 확인된 한계 (예: 노이즈 민감성, 과대적합 가능성, 계산 비용)

- 노이즈가 많은 데이터 및 이상치에 대한 민감성: 부스팅은 잘못 분류된 예제에 초점을 맞추기 때문에 노이즈가 많은 데이터 및 이상치에 민감할 수 있으며, 신중하게 관리하지 않으면 이에 과대적합될 수 있습니다.

- 과대적합 가능성: 부스팅 모델은 특히 너무 많은 기본 학습기가 추가되거나 학습기가 너무 복잡한 경우 훈련 데이터에 과대적합될 수 있습니다. 정규화 기법과 신중한 조정이 중요합니다.

- 계산 비용: 각 학습기가 이전 학습기에 의존하므로 순차적 훈련은 시간이 많이 걸릴 수 있습니다. 그러나 XGBoost 및 LightGBM과 같은 구현에는 속도 최적화가 적용되어 있습니다.

- 해석 가능성: 다른 앙상블 방법과 유사하게 해석하기 복잡할 수 있습니다.

- 매개변수 조정: 부스팅 알고리즘은 최적의 성능을 위해 신중한 조정이 필요한 많은 하이퍼파라미터를 갖는 경우가 많습니다.

부스팅 알고리즘의 "강점", 특히 높은 정확도를 달성하는 능력은 신중한 조정과 과대적합에 대한 인식이라는 "책임"을 동반합니다. 본질적으로 과대적합에 더 강한 배깅과 달리, 부스팅 모델은 제어되지 않으면(예: 학습률, 트리 깊이, 추정기 수, 정규화 등을 통해) 훈련 데이터를 쉽게 기억할 수 있습니다. 부스팅은 오류를 적합시켜 편향을 줄이는 것을 목표로 하는데, 이러한 공격적인 적합은 제어되지 않으면 노이즈 포착으로 이어질 수 있습니다. 문헌들은 부스팅이 과대적합되기 쉽다고 명시적으로 언급하며, 과대적합을 방지하기 위한 내장 정규화 기법과 하이퍼파라미터 조정의 필요성을 강조합니다. 조기 종료와 같은 기법도 부스팅에 중요합니다.

아래 표는 주요 부스팅 알고리즘의 특성을 요약한 것입니다.

표 1: 주요 부스팅 알고리즘의 특성

| 알고리즘 | 주요 특징 | 주요 강점 | 주목할 만한 약점/고려 사항 | 일반적인 적용 시나리오 |

| 에이다부스트(AdaBoost) | 샘플 가중치 재조정 | 단순함, 약한 학습기에서도 효과적 | 노이즈/이상치에 민감함 | 높은 정확도가 필요하고 데이터가 정형/표 형식인 일반 분류/회귀 |

| 그래디언트 부스팅 (GBM) | 잔차에 적합, 미분 가능한 손실 함수 사용 | 유연한 손실 함수 | 느릴 수 있음, 튜닝 필요 | 높은 정확도가 필요하고 데이터가 정형/표 형식인 일반 분류/회귀 |

| XGBoost | 정규화, 병렬 트리 구축, 결측치 처리 | 높은 정확도, 속도, 견고성 | 하이퍼파라미터가 많고 복잡할 수 있음 | 높은 정확도가 필요하고 데이터가 정형/표 형식인 일반 분류/회귀 |

| LightGBM | 히스토그램 기반, GOSS, EFB, 리프 단위 성장 | 대용량 데이터에서 매우 빠름, 메모리 효율적 | 작은 데이터에서는 과대적합될 수 있음, 매개변수에 민감함 | 높은 정확도가 필요하고 데이터가 정형/표 형식인 일반 분류/회귀, 특히 대규모 데이터셋 |

| CatBoost | 순서형 부스팅, 자동 범주형 처리, 대칭 트리 | 범주형 데이터에 탁월함, 과대적합에 강함 | 경우에 따라 LightGBM/XGBoost보다 느릴 수 있음, 메모리 사용량이 더 많을 수 있음 | 높은 정확도가 필요하고 데이터가 정형/표 형식인 일반 분류/회귀, 특히 범주형 특징이 많을 때 |

C. 스태킹 (스택 일반화)

- 핵심 메커니즘 및 이론적 기반 (메타 학습) 스태킹(Stacking), 또는 스택 일반화(stacked generalization)는 "메타 모델(meta-model)" 또는 "메타 학습기(meta-learner)"를 훈련하여 여러 다른 기본 모델(이종 학습기)의 예측을 결합하는 앙상블 방법입니다.

- 레벨-0 모델 (기본 학습기): 여러 다양한 모델(예: SVM, KNN, 랜덤 포레스트, 신경망)이 전체 훈련 데이터셋에서 훈련됩니다.

- 메타 모델 입력 생성: 이러한 기본 학습기의 홀드아웃 세트(또는 과대적합을 피하기 위한 교차 검증)에 대한 예측이 메타 모델의 입력 특징이 됩니다. 정보 유출 및 과대적합을 방지하기 위해 메타 학습기를 훈련하는 데 사용되는 데이터가 해당 단계에 대한 자체 예측 생성 중 기본 학습기에 의해 보이지 않는 것이 중요합니다.

- 레벨-1 모델 (메타 모델): 새로운 모델(예: 로지스틱 회귀, 신경망)이 이러한 "예측 특징"에 대해 훈련되어 최종 출력을 만듭니다. 메타 모델은 기본 모델의 예측을 결합하는 최적의 방법을 학습합니다.

- 경험적 성능: 강점 (예: 다양한 모델 강점 활용)

- 성능/정확도 향상: 스태킹은 다양한 유형의 모델 강점을 활용하여 전반적인 예측 성능을 향상시키는 것을 목표로 합니다. 메타 모델은 기본 모델 예측을 지능적으로 결합하는 방법을 학습하여 단일 모델이나 더 간단한 앙상블보다 더 복잡한 패턴을 포착할 수 있습니다.

- 모델 다양성 활용: 설계상 스태킹은 일반적으로 이종 기본 학습기를 사용하며, 이는 잠재적인 성공의 핵심입니다. 서로 다른 알고리즘은 서로 다른 가정을 하고 데이터의 서로 다른 측면을 포착합니다.

- 확인된 한계 (예: 복잡성, 계산 요구량)

- 계산 비용 및 시간: 스태킹은 여러 기본 모델을 훈련한 다음 추가 메타 모델을 훈련해야 하므로 계산 비용이 많이 들고 시간이 오래 걸리는 경우가 많습니다. 기본 모델 자체가 복잡한 경우(예: 랜덤 포레스트 또는 GBM과 같은 다른 앙상블) 비용이 크게 증가합니다.

- 복잡성: 특히 메타 모델 훈련을 위한 표본 외 예측을 생성하고 정보 유출을 피하기 위해 데이터 분할(예: k-겹 교차 검증 사용)을 관리하는 것은 스태킹을 올바르게 구현하는 것이 복잡할 수 있습니다.

- 과대적합 위험: 특히 메타 모델 훈련을 위한 데이터셋이 작거나 메타 모델 자체가 너무 복잡한 경우 과대적합의 위험이 있습니다. 간단한 메타 학습기를 사용하는 것이 종종 권장됩니다.

- 해석 가능성: 스태킹은 다층 구조로 인해 배깅이나 부스팅보다 훨씬 더 "블랙박스"일 수 있습니다.

스태킹의 성공은 기본 학습기의 다양성과 강도에 크게 좌우됩니다. 기본 학습기가 너무 유사하거나 모두 성능이 저조하면 메타 모델이 작업할 유용한 정보가 거의 없습니다. 이는 레벨-0 모델의 신중한 선택과 튜닝이 효과적인 스태킹을 위한 전제 조건임을 의미합니다. 메타 모델은 기본 학습기의 예측으로부터 학습하는데, 기본 학습기 예측이 상관 관계가 높거나(다양성 낮음) 일관되게 부정확하면(강도 낮음) 메타 모델의 특징 공간이 빈약하거나 오해의 소지가 있을 것입니다.

D. 비교 분석: 연구 사례로부터의 통찰

직접적인 비교는 데이터셋, 특정 문제, 튜닝 정도에 따라 크게 달라지는 경우가 많습니다.

- 네트워크 침입 탐지 예시:

- 한 종합 연구에서는 두 개의 네트워크 침입 데이터셋(RoEduNet-SIMARGL2021 및 CICIDS-2017)에 대해 개별 모델과 다양한 앙상블 방법(배깅, 스태킹, 블렌딩, 부스팅)을 평가했습니다.

- RoEduNet-SIMARGL2021 데이터셋에서는 랜덤 포레스트(RF), 결정 트리(DT), 평균화, 최대 투표, 스태킹, 가중 평균, 배깅, 블렌딩, 에이다부스트 등 많은 모델이 정확도, 정밀도, 재현율, F1 점수에서 완벽한 점수(1.00)를 달성했습니다. 이는 데이터셋 특성이나 특징 세트로 인해 많은 접근 방식이 매우 우수한 성능을 보였음을 시사합니다. 실행 시간은 크게 달랐으며, 개별 모델 중에서는 LR이 가장 빨랐고 앙상블 중에서는 배깅이 가장 빨랐지만, 고성능 앙상블 중 다수는 실행 시간이 길었습니다.

- CICIDS-2017 데이터셋에서는 RF, 배깅, 블렌딩, 가중 평균, 스태킹이 최상위 성능을 보였으며 (F1 >= 0.998), DT, CatBoost, MLP, XGBoost, 평균화도 매우 우수한 성능을 보였습니다. F1 점수가 완벽한 모델 중에서는 DT가 가장 시간 효율적이었습니다.

- 전반적으로 두 데이터셋 모두에서 앙상블 방법이 개별 모델보다 우수성을 보였습니다. 랜덤 포레스트는 지속적으로 최상위 성능 모델 중 하나로 나타났습니다.

- 한 종합 연구에서는 두 개의 네트워크 침입 데이터셋(RoEduNet-SIMARGL2021 및 CICIDS-2017)에 대해 개별 모델과 다양한 앙상블 방법(배깅, 스태킹, 블렌딩, 부스팅)을 평가했습니다.

- 일반적인 관찰:

- 한 연구에서는 121개 데이터셋에 대한 179개 알고리즘 비교에서 순차 알고리즘(부스팅)이 병렬 기법(배깅)을 능가하는 것으로 나타났습니다. 그러나 또 다른 연구에서는 무작위화 기법을 고려했을 때 57개 데이터셋 중 7개에서 배깅이 랜덤 포레스트와 부스팅보다 성능이 우수했습니다. 이는 어떤 단일 방법도 보편적으로 우수하지 않다는 "공짜 점심은 없다" 정리를 강조합니다.

- 한 평가에서는 CatBoost가 가장 높은 정밀도와 정확도를 보였으며 LightGBM, Extra Trees, 랜덤 포레스트가 그 뒤를 이었다고 언급되었습니다.

- 앙상블 방법의 성능은 상황(데이터셋 특성, 문제 유형, 특징 공학, 하이퍼파라미터 튜닝)에 크게 좌우됩니다. 한 데이터셋에서 여러 다양한 방법이 "완벽한 점수"를 얻는 것은 해당 특징을 고려할 때 문제가 상대적으로 강력한 학습기에게 "쉬웠거나", 또는 해당 특정 조건 하에서의 평가 자체가 최상위 모델 간의 미묘한 차이를 완전히 구별하지 못할 수 있음을 시사합니다.

- 한 연구에서는 121개 데이터셋에 대한 179개 알고리즘 비교에서 순차 알고리즘(부스팅)이 병렬 기법(배깅)을 능가하는 것으로 나타났습니다. 그러나 또 다른 연구에서는 무작위화 기법을 고려했을 때 57개 데이터셋 중 7개에서 배깅이 랜덤 포레스트와 부스팅보다 성능이 우수했습니다. 이는 어떤 단일 방법도 보편적으로 우수하지 않다는 "공짜 점심은 없다" 정리를 강조합니다.

아래 표는 주요 앙상블 학습 패러다임을 비교 요약한 것입니다.

표 2: 주요 앙상블 학습 패러다임 비교 개요

| 구분 | 배깅 (Bagging) | 부스팅 (Boosting) | 스태킹 (Stacking) |

| 핵심 원리 | 부트스트랩 집계 및 투표/평균화 | 순차적 오류 수정 및 가중 투표 | 기본 모델 예측으로부터의 메타 학습 |

| 주요 목표 | 분산 감소 | 편향 감소 | 다양성을 통한 성능 극대화 |

| 기본 학습기 특성 | 동종, 일반적으로 강력하지만 과대적합될 수 있음 | 동종, 일반적으로 약함 | 이종, 일반적으로 강력함 |

| 훈련 방식 | 병렬 | 순차 | 기본 학습기는 병렬, 메타 학습기는 순차 |

| 주요 장점 | 과대적합 감소, 안정적, 병렬화 가능 | 높은 정확도, 복잡한 패턴 처리 | 다양한 모델 강점 활용, 잠재적으로 가장 높은 정확도 |

| 일반적인 단점/과제 | 편향을 줄이지 못함, 자원 집약적일 수 있음 | 튜닝하지 않으면 과대적합/노이즈에 취약, 순차 훈련이 느릴 수 있음 | 매우 복잡함, 가장 높은 계산 비용, 메타 학습기 과대적합 위험 높음 |

앙상블 모델의 최적 적용을 위한 전략

앙상블 모델의 잠재력을 최대한 발휘하기 위한 핵심 전략들을 자세히 알아보겠습니다.

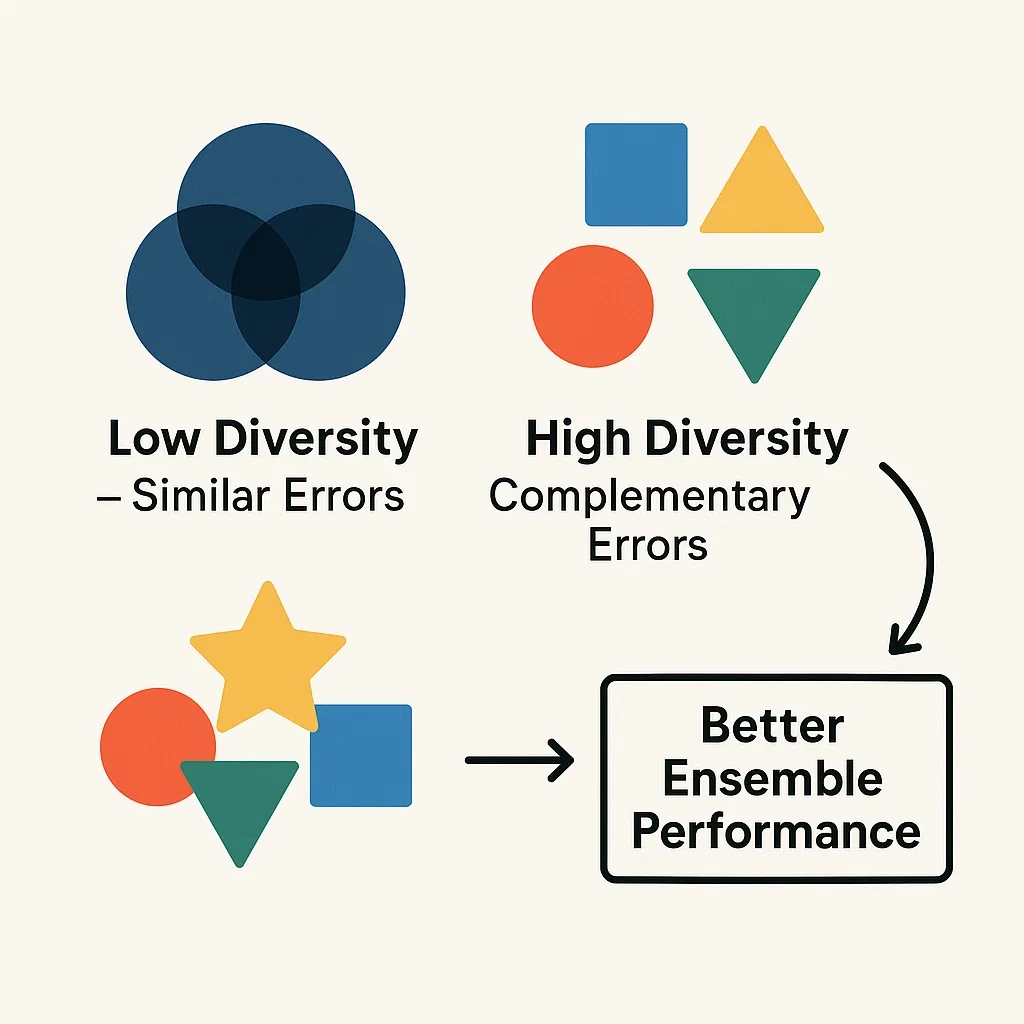

A. 기본 학습기 간 다양성 배양: 효과적인 앙상블의 초석

- 다양성의 이론적 중요성 기본 학습기 간의 다양성은 앙상블이 개별 구성원을 능가하는 성능을 발휘하기 위한 가장 중요한 요소입니다. 기본 학습기가 상관관계가 높고 유사한 오류를 범한다면, 이들의 결합은 거의 개선을 제공하지 못합니다. 최적의 앙상블은 정확하면서도 예측에서 가능한 한 많이 다른 분류기들로 구성됩니다. 앙상블의 효과는 기본 학습기 오류 간의 상관관계와 정확도에 크게 좌우되며, 더 높은 정확도와 더 큰 오류 다양성은 잠재적으로 향상된 앙상블 정확도로 이어집니다. 최근 연구는 "다양성의 통합 이론"을 제안하며, 다양성을 앙상블 손실의 편향-분산 분해(편향-분산-다양성 분해)에서 숨겨진 차원으로 구성합니다. 이는 다양성이 단독으로 최대화되어야 하는 것이 아니라 트레이드오프의 일부로 관리되어야 함을 시사합니다.

- 학습기 다양성 생성 기법

- 데이터 수준 전략:

- 배깅 (부트스트랩 샘플링): 각 기본 학습기를 훈련 데이터의 서로 다른 무작위 하위 집합(중복 허용)으로 훈련합니다.

- 페이스팅(Pasting): 배깅과 유사하지만 중복을 허용하지 않고 샘플링합니다.

- 적응적 리샘플링/가중치 부여 (부스팅): 훈련 인스턴스의 가중치를 순차적으로 재조정하여 후속 학습기가 이전에 잘못 분류된 예제에 집중하도록 합니다.

- 특징 수준 전략:

- 무작위 부분 공간 방법(Random Subspace Method): 각 기본 학습기를 특징의 무작위 하위 집합으로 훈련합니다. 랜덤 포레스트가 이를 통합합니다.

- 앙상블 특징 선택: 다양한 특징 하위 집합을 사용하여 다양성 촉진합니다.

- 알고리즘 수준 전략:

- 서로 다른 알고리즘 사용 (이종 앙상블): 스태킹은 명시적으로 서로 다른 알고리즘으로 훈련된 기본 학습기를 사용합니다.

- 하이퍼파라미터 변경: 동일한 유형의 기본 학습기를 서로 다른 하이퍼파라미터 설정으로 훈련합니다.

- 서로 다른 초기화: 신경망과 같은 모델의 경우 가중치에 대해 서로 다른 무작위 초기화를 사용하면 다양한 솔루션으로 이어질 수 있습니다.

- 무작위성 주입: 랜덤 포레스트와 같은 일부 알고리즘은 학습 과정에 직접 무작위성을 주입합니다 (예: 분할 시 무작위 특징 선택).

- 출력 수준 전략:

- 출력 스미어링(Output Smearing): 출력 공간에 무작위 노이즈 유도합니다.

- 순차적 생성 전략:

- 음의 상관 학습(Negative Correlation Learning, NCL): 손실 함수에 페널티 항을 추가하여 새로운 모델이 기존 모델과 음의 상관관계를 갖도록 장려합니다.

- 스냅샷 앙상블링(Snapshot Ensembling): 단일 신경망 훈련 중 서로 다른 에포크에서 모델 캡처합니다.

- 음의 상관 학습(Negative Correlation Learning, NCL): 손실 함수에 페널티 항을 추가하여 새로운 모델이 기존 모델과 음의 상관관계를 갖도록 장려합니다.

- 데이터 수준 전략:

B. 기본 학습기 예측의 효과적인 집계

- 일반적인 접근 방식: 투표, 평균화, 가중 평균화

- 최대 투표 (하드 투표, Max Voting): 분류의 경우 각 모델이 클래스에 투표하고, 가장 많은 표를 얻은 클래스가 최종 예측이 됩니다. 이는 간단하고 일반적인 방법입니다.

- 평균화(Averaging): 회귀의 경우 개별 모델의 예측을 평균하여 최종 예측을 얻습니다. 분류의 경우 예측된 확률에 적용될 수 있습니다(소프트 투표).

- 소프트 투표(Soft Voting): 분류에서 기본 학습기가 각 클래스에 대한 확률 추정치를 출력하는 경우, 이러한 확률을 평균화(또는 가중 평균화)하고 평균 확률이 가장 높은 클래스를 선택합니다. 소프트 투표는 분류기에서 더 많은 정보를 사용하므로 하드 투표보다 종종 더 효과적입니다.

- 가중 평균화/투표(Weighted Averaging/Voting): 개별 모델의 예측에 서로 다른 가중치를 할당하며, 종종 인지된 성능, 신뢰성 또는 확신도를 기반으로 합니다. 가중치는 학습되거나 경험적으로 설정될 수 있습니다. 부스팅은 본질적으로 가중 결합을 사용합니다.

- 고급 집계: 스태킹의 메타 모델 스태킹은 기본 학습기의 예측을 결합하기 위해 전용 메타 학습기를 사용합니다. 메타 학습기는 기본 모델의 "폴드 외부(out-of-fold)" 예측에 대해 훈련되어 특정 작업에 대해 이를 가중하거나 결합하는 최적의 방법을 효과적으로 학습합니다. 이는 단순 평균화 또는 투표보다 기본 모델 예측 간의 더 복잡한 관계를 포착할 수 있습니다.

집계 방법의 선택은 앙상블 유형 및 기본 학습기의 특성과 무관하지 않습니다. 예를 들어, 단순 평균화는 기본 학습기가 유사한 품질을 갖고 비교 가능한 데이터 하위 집합에서 훈련된 것으로 가정되는 배깅에 자연스럽습니다. 가중 평균화 또는 학습된 집계(스태킹)는 기본 학습기가 이종이거나 성능 수준이 크게 다를 때 더욱 중요해집니다.소프트 투표는 확률 점수를 활용하여 하드 투표보다 기본 분류기에서 더 미묘한 정보를 포착합니다. 이는 예측된 클래스 레이블 자체뿐만 아니라 예측에 대한 각 분류기의 신뢰도를 고려하기 때문에 종종 더 나은 성능으로 이어집니다. 문헌들은 소프트 투표를 확률 추정치를 평균화하는 것으로 설명합니다.

C. 앙상블 아키텍처를 위한 하이퍼파라미터 최적화

- 하이퍼파라미터 튜닝의 중요성 하이퍼파라미터 튜닝은 앙상블을 포함한 모든 머신러닝 모델의 성능을 최대화하는 데 매우 중요합니다. 기본 하이퍼파라미터는 특정 문제에 대해 거의 최적이 아닙니다. 앙상블의 경우 튜닝에는 기본 학습기의 하이퍼파라미터뿐만 아니라 앙상블 구조 자체에 특정한 매개변수도 최적화하는 것이 포함됩니다.

- 널리 사용되는 앙상블 알고리즘의 중요 하이퍼파라미터

- 랜덤 포레스트:

- n_estimators: 포레스트의 트리 수.

- max_depth: 각 트리의 최대 깊이. 과대적합 제어에 중요합니다.

- min_samples_split: 내부 노드를 분할하는 데 필요한 최소 샘플 수.

- min_samples_leaf: 리프 노드에 있어야 하는 최소 샘플 수.

- max_features: 최상의 분할을 찾을 때 고려할 특징 수.

- 그래디언트 부스팅 (GBM, XGBoost, LightGBM):

- n_estimators: 부스팅 단계(트리) 수.

- learning_rate (또는 eta): 각 트리의 기여도를 축소합니다. 값이 낮을수록 일반적으로 더 많은 트리가 필요하지만 일반화 성능을 향상시킬 수 있습니다.

- max_depth: 개별 트리의 최대 깊이.

- subsample: 개별 기본 학습기를 적합시키는 데 사용할 샘플 비율.

- colsample_bytree (및 변형): 개별 기본 학습기를 적합시키는 데 사용할 특징 비율.

- 정규화 매개변수 (예: XGBoost의 reg_alpha (L1), reg_lambda (L2)).

- LightGBM 특정: num_leaves, min_data_in_leaf, boosting_type (gbdt, dart, goss).

- 랜덤 포레스트:

- 효과적인 튜닝을 위한 모범 사례 및 방법론

- 검색 공간 정의: 각 하이퍼파라미터에 대해 가능한 값의 범위를 지정합니다.

- 샘플링 방법:

- 그리드 검색(Grid Search): 미리 정의된 그리드에서 가능한 모든 하이퍼파라미터 조합을 시도합니다. 계산 비용이 많이 들 수 있습니다.

- 랜덤 검색(Random Search): 주어진 분포에서 하이퍼파라미터 조합을 무작위로 샘플링합니다. 종종 그리드 검색보다 효율적입니다.

- 베이지안 최적화 (예: Optuna): 이전 시도의 결과를 사용하여 평가할 다음 하이퍼파라미터 세트를 선택하는 반복적 접근 방식으로, 종종 좋은 솔루션을 찾는 데 더 효율적입니다.

- 평가 기준 및 교차 검증: 모델 성능을 판단하기 위한 지표(예: 정확도, F1 점수, RMSE)를 정의하고 교차 검증(예: k-겹 CV)을 사용하여 성능에 대한 강력한 추정치를 얻고 단일 검증 분할에 대한 과대적합을 방지합니다.

D. 앙상블 모델의 과대적합에 대한 선제적 관리

- 고유한 과대적합 저항성 및 원인

- 배깅 (예: 랜덤 포레스트): 서로 다른 데이터 하위 집합에서 훈련된 다양한 트리의 예측을 평균화하기 때문에 일반적으로 과대적합에 강하며, 이는 분산을 줄입니다.

- 부스팅: 신중하게 제어하지 않으면 배깅보다 과대적합되기 쉽습니다. 오류에 대한 순차적 초점은 특히 잡음이 많은 데이터셋이나 너무 많은 반복으로 인해 모델이 노이즈를 학습하도록 유도할 수 있습니다.

- 스태킹: 메타 모델이 너무 복잡하거나 기본 학습기 훈련에서 메타 학습기 훈련으로 정보 유출이 있는 경우 과대적합될 수 있습니다.

- 취약한 앙상블의 과대적합 완화 전략

- 정규화 (특히 부스팅의 경우): 모델 가중치/매개변수에 대한 L1 및 L2 정규화 (예: XGBoost), 축소 (학습률), 트리 복잡도 제어 (max_depth, min_samples_leaf 제한).

- 조기 종료(Early Stopping): 훈련 중 검증 세트에서 성능을 모니터링하고(특히 부스팅과 같은 반복적 방법의 경우) 성능이 더 이상 향상되지 않으면 중지하여 노이즈 학습 방지.

- 하위 샘플링 (확률적 그래디언트 부스팅, Stochastic Gradient Boosting): 각 부스팅 반복에 대해 훈련 데이터의 일부(행 하위 샘플링) 및/또는 특징(열 하위 샘플링)을 사용하여 랜덤 포레스트와 유사한 무작위성 도입.

- 교차 검증(Cross-Validation): 강력한 모델 평가 및 하이퍼파라미터 튜닝을 위해 k-겹 교차 검증을 사용하면 모델이 잘 일반화되도록 하는 데 도움이 됨. 스태킹의 경우 메타 학습기를 위한 표본 외 예측을 생성하는 데 CV가 중요.

- 가지치기 (모델 가지치기 / 특징 선택): 덜 중요한 특징을 제거하거나 기본 모델 단순화. 앙상블 가지치기는 중복되거나 해로운 기본 학습기를 제거하여 도움이 될 수도 있음.

- 데이터 증강(Data Augmentation): 훈련 데이터의 다양성과 크기를 늘리면 모델이 더 잘 일반화되는 데 도움이 될 수 있음.

- 스태킹에서의 신중한 데이터 분할: 메타 학습기가 자체 훈련 중 해당 기본 학습기에 의해 보이지 않는 데이터에 대해 만들어진 기본 학습기의 예측에 대해 훈련되도록 보장.

E. 계산 효율성 및 확장성 향상

- 앙상블 가지치기: 최적의 학습기 하위 집합 선택 앙상블 가지치기(Ensemble Pruning)는 기본 학습기의 하위 집합을 선택하여 앙상블의 크기를 줄이는 것을 목표로 하며, 중복되거나 해로운 모델을 제거하여 효율성(예측 시간 및 모델 크기 감소)을 향상시키고 때로는 예측 성능까지 향상시킬 수 있습니다.

- 효율적인 기본 학습기의 전략적 선택 기본 학습기의 선택은 계산 비용에 큰 영향을 미칩니다. 본질적으로 더 빠르거나 간단한 기본 학습기(예: 선형 모델, 더 간단한 결정 트리)를 사용하면 전체 앙상블 훈련 및 예측 시간을 줄일 수 있습니다. LightGBM과 같은 알고리즘은 대규모 데이터셋에서 속도와 효율성을 위해 설계되었습니다.

- 앙상블 모델 압축을 위한 지식 증류 지식 증류(Knowledge Distillation)는 더 작고 효율적인 "학생" 모델을 훈련하여 더 크고 복잡한 "교사" 모델(앙상블일 수 있음)의 동작을 모방하는 것을 포함합니다. 이는 대규모 앙상블의 성능 대부분을 유지하면서 모델 크기와 추론 시간을 크게 줄여 자원이 제한된 환경에서의 배포를 가능하게 할 수 있습니다.

- 최적의 기본 학습기 수 결정 기본 학습기를 더 많이 추가하면 일반적으로 어느 시점까지 성능이 향상되지만, 그 이후에는 수익이 감소하거나 과대적합이 발생할 수 있습니다 (특히 부스팅에서). 성능이 낮은 모델이 추가되면 성능이 저하될 수도 있습니다. 최적의 수는 학습기가 추가됨에 따라 검증 세트에서 성능을 모니터링하여 경험적으로 결정되는 경우가 많습니다.

- 병렬화 배깅 방법과 스태킹의 기본 학습기 훈련 단계는 기본 모델이 독립적으로 훈련되므로 본질적으로 병렬화 가능합니다. 여러 코어/머신을 사용할 수 있는 경우 훈련 시간을 크게 줄일 수 있습니다. 부스팅은 본질적으로 순차적이지만 일부 구현(XGBoost, LightGBM 등)은 각 반복 내 트리 구축 과정의 일부를 병렬화했습니다.

효율적인 부스팅 라이브러리(XGBoost, LightGBM, CatBoost)의 등장은 가지치기와 같은 사후 방법뿐만 아니라 앙상블 프레임워크 자체 내의 알고리즘 혁신과 영리한 엔지니어링을 통해 상당한 계산 이득을 얻을 수 있음을 보여줍니다.

아래 표는 앙상블 모델 성능 최적화를 위한 주요 전략을 요약한 것입니다.

표 3: 앙상블 모델 성능 최적화를 위한 주요 전략

| 최적화 영역 | 구체적인 기법/접근 방식 | 메커니즘 |

| 학습기 다양성 향상 | 배깅, 무작위 부분 공간, 서로 다른 알고리즘, NCL | 기본 모델이 서로 다른 오류를 만들도록 유도 |

| 효과적인 집계 | 투표, 평균화, 스태킹 | 기본 모델 예측을 결합하여 최종 결정 |

| 하이퍼파라미터 최적화 | 그리드/랜덤 검색, 베이지안 최적화 | 최적의 모델 구성 매개변수 찾기 |

| 과대적합 관리 | 정규화, 조기 종료, 교차 검증, 하위 샘플링 | 모델이 훈련 데이터 노이즈를 학습하는 것을 방지 |

| 계산 효율성 | 가지치기, 효율적인 학습기, 지식 증류, 병렬화 | 훈련 및 예측 시간/자원 감소 |

앙상블 학습의 새로운 지평: 현재 연구 및 미래 전망

앙상블 학습 분야는 역동적으로 발전하며 다음과 같은 흥미로운 연구 주제들이 부상하고 있습니다.

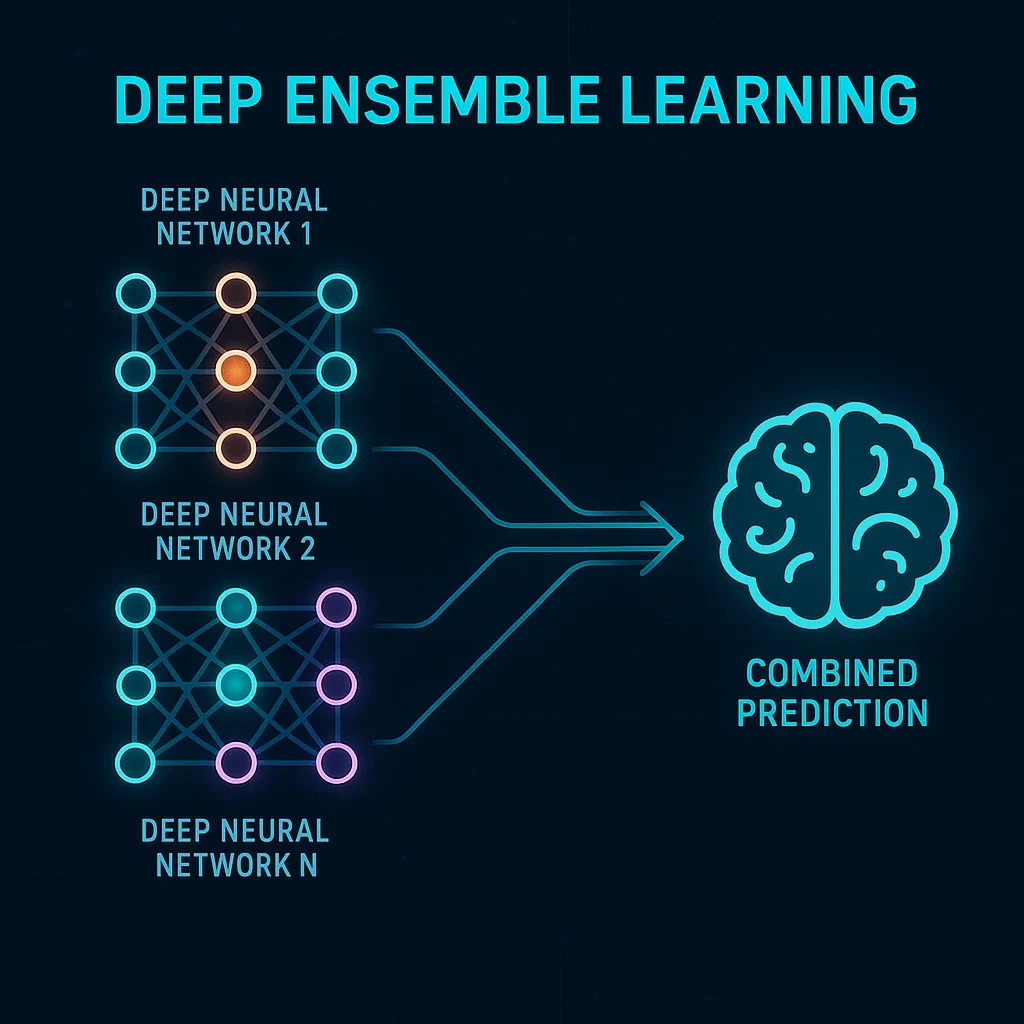

A. 딥 앙상블 학습의 부상: 앙상블과 신경망의 시너지

딥 앙상블 학습은 딥러닝 모델의 강점(예: 복잡한 데이터로부터의 자동 특징 추출)과 앙상블 방법의 이점(예: 일반화 향상, 불확실성 정량화)을 결합합니다.

- 방법론:

- 딥 뉴럴 네트워크(DNN)를 기본 학습기로 사용하여 기존 앙상블 기법(배깅, 부스팅, 스태킹) 적용.

- 암시적 앙상블(Implicit Ensembles): 드롭아웃, 드롭커넥트, 확률적 깊이와 같은 기법으로, 단일 모델이 훈련되지만 추론 중에는 앙상블처럼 동작하며 종종 매개변수를 공유합니다. 이는 명시적 앙상블에 비해 계산 비용을 줄입니다.

- 명시적 앙상블(Explicit Ensembles): 여러 개의 서로 다른 DNN을 훈련하고 예측을 결합 (예: 단일 훈련 실행의 서로 다른 에포크에서 모델을 사용하는 스냅샷 앙상블링).

- 다양성 유도: 계산 비용이 많이 드는 DNN 간의 다양성 유도가 과제입니다. 전략에는 서로 다른 초기화, 서로 다른 데이터 하위 집합에서의 훈련, 또는 DNN을 위한 음의 상관 학습(NCL)과 같은 특수 기법이 포함됩니다.

- 응용 분야: 의료(의료 영상 분석, 질병 예측), 이미지 분류, 예측, 음성 인식 및 DNN이 뛰어난 기타 여러 영역에서 널리 사용됩니다.

- 과제 및 향후 방향: 여러 DNN의 높은 훈련 비용, 암시적/명시적 딥 앙상블에서 효과적으로 다양성 유도, 딥 앙상블을 위한 모델 선택 기준 및 최적 융합 전략 개발, 비지도 및 준지도 학습, 강화 학습으로 확장.

정확도 외에도 딥 앙상블의 주요 동인은 불확실성 정량화 및 견고성 향상이며, 이는 의료 진단이나 자율 주행과 같은 고위험 응용 분야에서 매우 중요합니다. 단일 DNN은 예측에 대해 과신할 수 있는 반면, 앙상블은 예측 분포를 제공하여 불확실성에 대한 더 나은 감각을 제공할 수 있습니다.

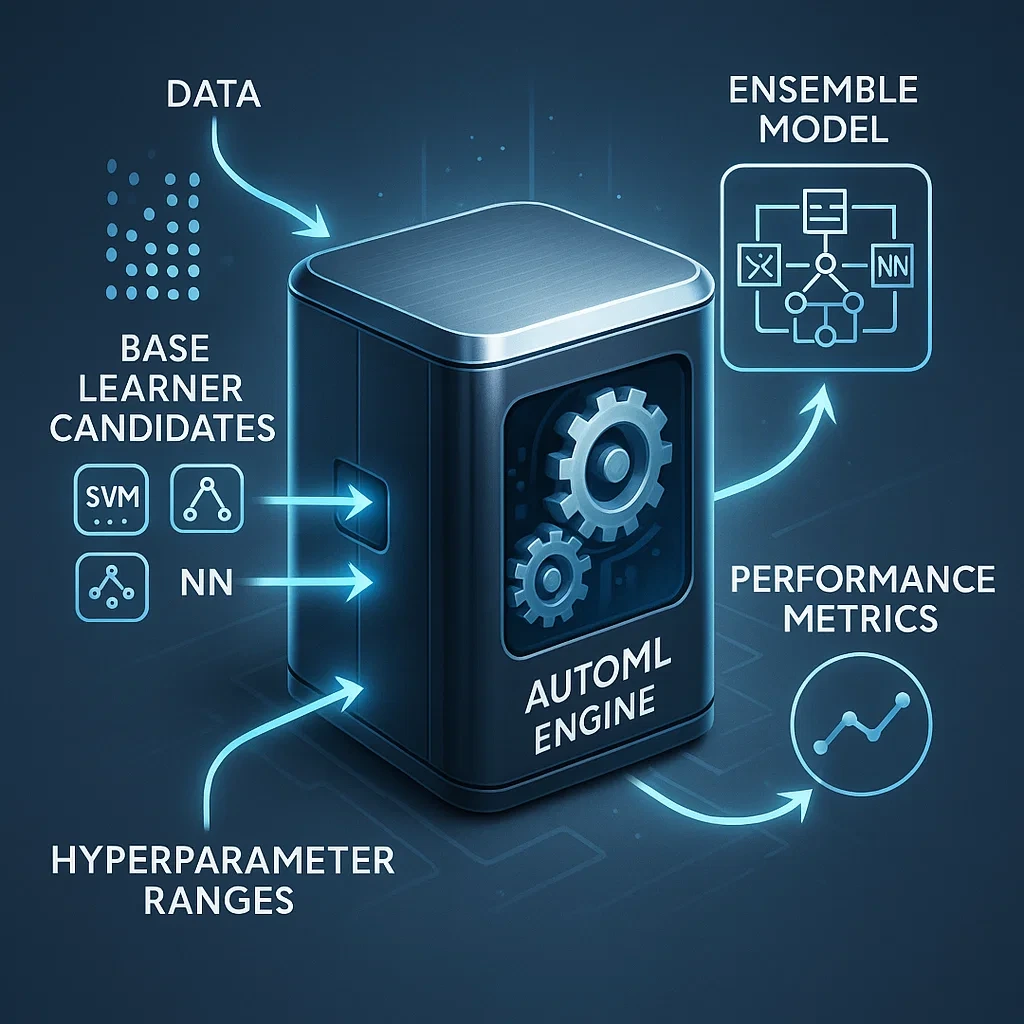

B. 앙상블 설계 및 최적화에서의 자동화된 머신러닝 (AutoML)

AutoML은 모델 선택, 하이퍼파라미터 최적화, 심지어 특징 공학을 포함하여 머신러닝 적용의 전 과정을 자동화하는 것을 목표로 합니다.

- 앙상블을 위한 AutoML: AutoML 시스템은 후보 풀에서 기본 학습기 선택, 기본 학습기와 앙상블 방법 모두에 대한 하이퍼파라미터 튜닝, 스태킹 아키텍처 구성(예: 계층 및 메타 학습기 결정)을 포함하여 최적의 앙상블 구성을 자동으로 검색할 수 있습니다.

- 연구에 따르면 KNORA-AutoML과 같은 AutoML 접근 방식이 최적화된 ML 모델의 기존 앙상블보다 성능이 우수할 수 있습니다. 학생 성적 예측 연구에서도 AutoML의 GBM 모델이 우수한 성능을 보였습니다.

- AutoML은 하이퍼파라미터 최적화(예: Optuna) 및 해석 가능성(예: SHAP)을 앙상블 알고리즘과 통합할 수 있습니다.

- 과제: AutoML은 데이터셋의 다양한 하위 집합에 대한 최적화 방법으로 생성된 많은 모델 중에서 최적의 모델을 선택하는 데 어려움을 겪을 수 있습니다.

앙상블을 위한 AutoML은 정교한 앙상블 기법에 대한 접근을 민주화합니다. 효과적인 앙상블, 특히 스태킹 또는 정교하게 조정된 부스팅 모델을 설계하려면 상당한 전문 지식과 실험이 필요합니다. AutoML은 이러한 복잡한 검색 과정의 대부분을 자동화하여 비전문가도 강력한 앙상블 방법을 더 쉽게 사용할 수 있도록 합니다.

C. 고급 이론적 프레임워크: 편향-분산-다양성 분해

기존의 앙상블 이해는 종종 편향-분산 트레이드오프에 초점을 맞추었지만, 최근 연구는 다양성의 역할을 공식화했습니다. "다양성의 통합 이론"은 회귀 및 분류와 다양한 손실 함수 모두에 적용 가능한 앙상블 오류에 대한 혁신적인 편향-분산-다양성 분해 프레임워크를 제안합니다. 이 이론은 다양성이 앙상블 손실의 숨겨진 차원이며, 앙상블 구성원 간의 통계적 종속성과 관련된 모델 적합도를 측정함을 보여줍니다. 이는 다양성을 순진하게 최대화해서는 안 되며, 관리해야 할 편향/분산/다양성 트레이드오프가 있음을 의미합니다. 이 프레임워크는 이러한 세 가지 오류 구성 요소에 상보적인 효과를 갖는 전략을 결합하여 새로운 앙상블 학습 알고리즘의 체계적인 설계를 안내할 수 있습니다.

편향-분산-다양성 분해는 앙상블이 성공하거나 실패하는 이유를 이해하기 위한 더 완전한 진단 도구를 제공합니다. 이를 통해 연구자들은 성능 저하가 기본 학습기의 높은 편향, 기본 학습기의 높은 분산, 또는 불충분하거나 해로운 다양성 때문인지 정확히 찾아낼 수 있습니다.

D. 새로운 알고리즘 및 유망한 연구 방향

- 체계적인 설계 접근 방식: SA2DELA(Systematic Approach to Design Ensemble Learning Algorithms)는 오류 분해를 기반으로 기존 전략을 결합하여 새로운 앙상블 알고리즘을 만드는 보다 구조화된 방법으로의 추세를 보여줍니다.

- 분해 기반 딥 앙상블: 교통 흐름 예측과 같은 작업의 경우 시계열을 더 간단한 신호로 분해하고, 이에 대한 딥러닝 모델을 구축한 다음 앙상블링하는 것이 우수성을 보여줍니다.

- LLM 앙상블: 새로운 연구는 다양성, 출력 품질 및 유연성을 향상시키기 위해 텍스트 및 코드 생성을 위한 대규모 언어 모델(LLM) 앙상블링에 중점을 둡니다.

- 다중 모드 학습에서의 앙상블: 전반적인 성능을 향상시키기 위해 서로 다른 양식(예: 행동 인식을 위한 RGB, 깊이, 열화상 IR)의 출력을 통합하기 위해 앙상블 기법이 적용되고 있습니다.

- 부스팅/배깅의 과대적합 해결: 지속적인 연구는 배깅의 제한된 다양성 및 부스팅의 과대적합과 같은 단점을 해결하기 위해 기존 기법의 수정을 탐구하는 것을 목표로 합니다.

- 미분 가능한 모델 선택: e2e-CEL과 같은 프레임워크는 미분 가능한 최적화를 사용하여 모델 선택을 훈련 과정에 통합하여 앙상블이 특화된 합의 규칙을 학습하도록 허용합니다.

- 향후 동향 (앙상블에 영향을 미치는 일반 AI): 다중 모드 AI, 전이 학습, 설명 가능성 및 해석 가능성, 개인 정보 보호 기술.

앙상블 알고리즘의 체계적이고 이론적으로 근거 있는 설계로의 추세는 해당 분야의 성숙을 의미합니다. 이는 종종 발견적 방법과 경험적 평가에 의존했던 과거에서 벗어나 앙상블 방법론의 기본 원리에 대한 더 깊은 이해를 향해 나아가고 있음을 보여줍니다.

결론 및 권고 사항

앙상블 학습은 단일 모델의 한계를 극복하고 예측 성능을 향상시키는 강력한 머신러닝 패러다임으로 확고히 자리매김했습니다. 본 보고서에서 검토한 다양한 연구 결과는 앙상블 모델이 정확도 향상, 견고성 증대, 편향-분산 트레이드오프의 효과적인 관리 등 다방면에 걸쳐 일관되게 우수한 성능을 제공함을 입증합니다. 배깅, 부스팅, 스태킹과 같은 핵심 기법들은 각각 고유한 강점과 적용 영역을 가지며, 랜덤 포레스트, XGBoost, LightGBM, CatBoost와 같은 구체적인 알고리즘들은 특정 유형의 데이터와 문제에서 최첨단 결과를 달성하는 데 핵심적인 역할을 합니다.

앙상블 모델의 성공적인 활용은 몇 가지 핵심 원칙에 달려 있습니다. 첫째, 기본 학습기 간의 다양성 확보는 앙상블 성능 향상의 가장 중요한 요소입니다. 둘째, 적절한 집계 방법의 선택은 기본 학습기들의 예측을 효과적으로 결합하는 데 필수적입니다. 셋째, 세심한 하이퍼파라미터 튜닝은 기본 학습기와 앙상블 구조 모두의 잠재력을 최대한 발휘하는 데 중요합니다. 넷째, 특히 부스팅이나 복잡한 스태킹 모델의 경우 과대적합을 선제적으로 관리하는 것이 견고한 일반화 성능을 보장하는 데 결정적입니다. 마지막으로, 계산 비용과 효율성은 실제 적용 가능성을 결정하는 중요한 고려 사항입니다.

머신러닝 실무자가 앙상블 모델을 최적으로 활용하기 위한 권고 사항은 다음과 같습니다.

- 문제 및 데이터 이해: 해결하려는 문제의 특성(분류, 회귀)과 데이터의 특성(크기, 노이즈 수준, 특징 유형, 편향/분산 문제)을 명확히 파악하십시오. 이는 적절한 앙상블 유형(배깅, 부스팅, 스태킹)과 기본 학습기 선택의 기초가 됩니다.

- 다양성 우선 확보: 기본 학습기 간의 다양성을 극대화하기 위한 전략을 적극적으로 사용하십시오. 데이터 샘플링(부트스트래핑), 특징 샘플링(랜덤 부분 공간), 서로 다른 알고리즘 사용, 학습률 및 초기화 변형 등 다양한 기법을 조합하여 적용하는 것을 고려하십시오.

- 적절한 앙상블 기법 선택:

- 분산 감소가 주 목표이고 과대적합이 우려되는 경우, 랜덤 포레스트와 같은 배깅 기법을 우선 고려하십시오.

- 편향 감소와 높은 정확도가 필요하고 계산 자원이 충분하며 노이즈 관리가 가능한 경우, XGBoost, LightGBM, CatBoost와 같은 고급 부스팅 알고리즘을 탐색하십시오.

- 최상의 예측 성능을 추구하고 모델 복잡성 및 계산 비용을 감당할 수 있다면, 다양한 강력한 기본 모델을 결합하는 스태킹을 시도해 볼 수 있습니다.

- 체계적인 하이퍼파라미터 최적화: 그리드 검색, 랜덤 검색 또는 베이지안 최적화와 같은 방법을 사용하여 기본 학습기와 앙상블 자체의 하이퍼파라미터를 신중하게 튜닝하십시오. 교차 검증을 통해 일반화 성능을 평가하십시오.

- 과대적합 적극 방지: 특히 부스팅 및 스태킹의 경우 정규화, 조기 종료, 하위 샘플링, 드롭아웃(신경망 기반 시) 등의 기법을 활용하여 과대적합을 방지하십시오. 스태킹에서는 메타 학습기 훈련 시 정보 유출을 방지하기 위해 데이터 분할에 각별히 주의하십시오.

- 계산 예산 고려: 앙상블의 훈련 시간, 예측 지연 시간, 모델 크기 등 계산 비용을 고려하십시오. 필요한 경우 앙상블 가지치기, 더 가벼운 기본 학습기 사용, 지식 증류 또는 병렬 처리 활용을 통해 효율성을 개선하십시오.

- 단순한 방법부터 시작: 복잡한 앙상블을 바로 구축하기보다는, 잘 이해된 단일 모델의 성능을 기준으로 삼고, 점진적으로 배깅, 부스팅 등의 기본적인 앙상블 기법을 적용하여 성능 향상을 확인하십시오.

- 최신 연구 동향 주시: 딥 앙상블 학습, AutoML을 활용한 앙상블 최적화, 편향-분산-다양성 분해와 같은 이론적 발전을 주시하여 새로운 접근 방식을 탐색하십시오.

앙상블 학습 분야는 지속적으로 발전하고 있으며, 딥러닝과의 융합, AutoML을 통한 자동화, 그리고 편향-분산-다양성 분해와 같은 보다 깊이 있는 이론적 이해를 바탕으로 더욱 정교하고 강력한 모델들이 등장할 것으로 예상됩니다. 이러한 발전을 통해 앙상블 모델은 앞으로도 다양한 머신러닝 응용 분야에서 핵심적인 역할을 수행할 것입니다.

원자력 vs 신재생 에너지 토막 상식 공부하러가기

2025.05.24 - [자연과학&공학/에너지] - [상식] 신재생 에너지 vs 원자력 에너지, 딱 요점만 정리!

[상식] 신재생 에너지 vs 원자력 에너지, 딱 요점만 정리!

전 세계는 지금 에너지 대전환의 기로에 서 있습니다. 기후변화 대응과 탄소중립 목표 달성은 우리가 에너지를 사용하는 방식을 근본적으로 바꾸고 있습니다. 2050년 탄소중립을 선언하고 국가

sucksa-himdleall.tistory.com

주식 공부하러가기~

2025.05.17 - [재테크/주식] - [한국증시] 상한가 빈도와 풀림 비율에 대한 통계는 어떨까?

[한국증시] 상한가 빈도와 풀림 비율에 대한 통계는 어떨까?

2025.05.18 - [주식] - [국내주식] 2015년 이후 코스피 vs 코스닥, 상한가 도달 얼마나 자주? '상따' 매매의 명암국내 주식 시장에서 '상한가'는 많은 투자자에게 짜릿한 수익률의 기회로 인식됩니다. 하

sucksa-himdleall.tistory.com

'자연과학&공학 > 인공지능 AI' 카테고리의 다른 글

| [IT/인터넷] 용도별 생성형 AI 순위 (2025년 5월 기준) (11) | 2025.06.04 |

|---|